星图的应用(背景是有云雾的天空)

增强现实(Augmented Reality,缩写成 AR)技术现在经常出现在新应用和描绘未来的影片中。据科学家预测,它几乎可以出现在你未来生活的各个角落,能把电子信息和现实结合,让你看到一个更有层次的世界。

这是不是 AR ?

现在,即使你没有天文望远镜,也可以真切地看到遥远的行星;

即使你身在北半球,也可以饱览南天的星座。你需要做的事情,只是拿出 iPhone 或iPad,下载一个 App。

打开这个应用,将你的iPhone或者iPad指向任意方位,这个方位上的真实的星空便会呈现在你的设备屏幕上,哪怕是在白天!这款叫“星图”的应用程序具有增强现实的功能。

那么,它是怎么“增强”我们看到的“现实”的呢?

当你打开这款应用时,你手机系统内的指南针会进行校准,它会和手机中的全球定位系统(GPS)以及重力系统一起准确定位,模拟出你的视角。

当你将设备对准星空的某个方位时,就算天空上乌云密布,或者遇到雾霾天气,设备上的屏幕都会呈现这个方位上的星星。

你的手机仿佛变成了一架迷你天文望远镜,而这架“天文望远镜”还提供了搜索功能,你可以调出对应星系、星球的注释和说明。

这个增强现实的应用,是利用现有设备,获取你的位置、视角等信息,然后调出星图数据库中对应的星空图像,这些图像也确实是由先进的天文望远镜或探测器拍摄的,因为与你所在的实际地点相联系,所以就像是自己亲眼看到的一样。

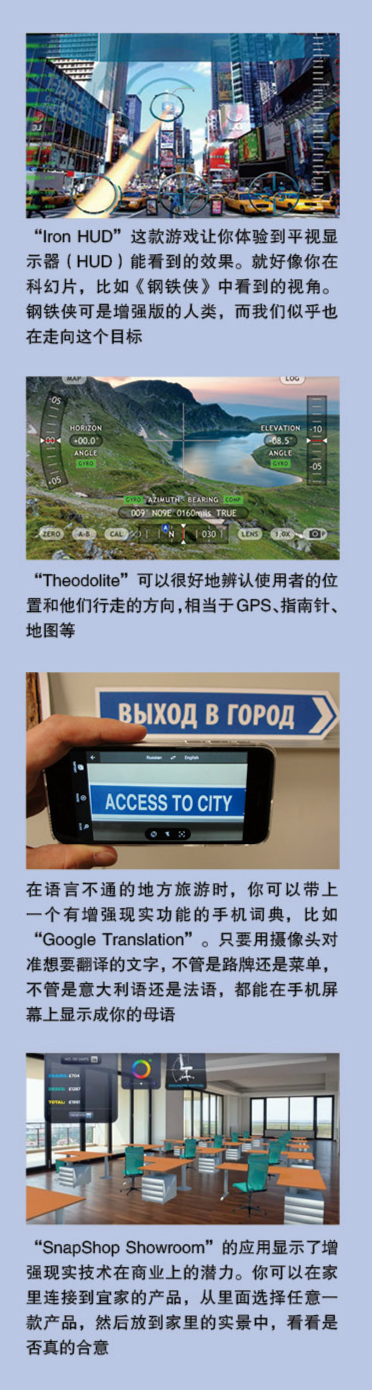

除了星图,这一类的应用已经随处可见。

一些博物馆和科学中心将增强现实的手持设备应用在展览品上。

加拿大多伦多市的皇家安大略博物馆就在恐龙骨骼化石的周围配备了许多 iPad,只要转动这些 iPad,将摄像头对准恐龙骨骼的任意位置,就能在屏幕上看到该部位的皮肤,看到活灵活现的恐龙。

增强现实就是补充现实

通过上面的例子可以看出,“增强现实”就是在真实场景上添加一些跟该场景相关的影像和信息。你首先获得真实世界的信息数据,再由计算机推算、搜索或模拟出与之对应的虚拟的添加物,并叠加到真实场景中去。

手机之所以可以担当互动的工具,是因为它里面有很多感知现实世界的“器官”,比如 GPS、指南针、重力计、麦克风、处理器,还有最重要的摄像头。现实场景的影像由手机的摄像头实时拍摄,而那些添加物,比如天上的星图、建筑介绍或者沙发图片等,其来源往往是本机已经存储的内容,或者是通过互联网搜索到的信息,又或者是通过程序将直接获得的信息进行处理(比如翻译)并输出的结果。

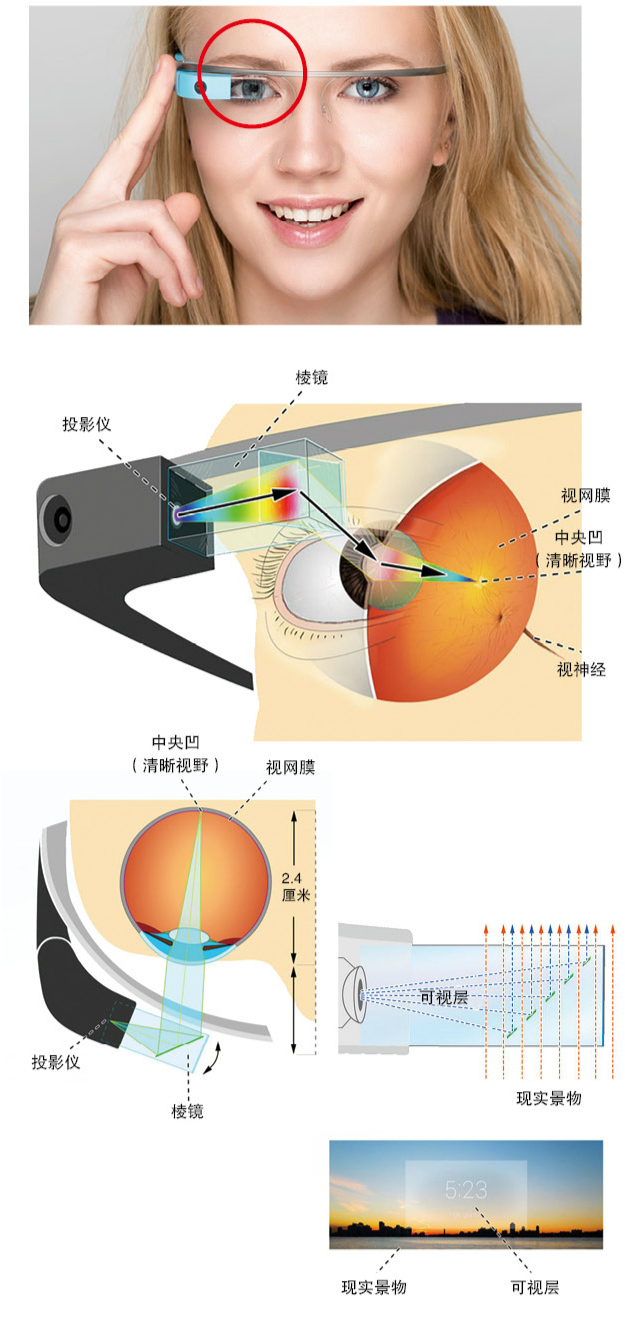

手持设备虽然很普及,但需要用手拿着或举着,而且通过摄像头看到的和眼睛看到的东西并不一样,你眼睛看到的是三维的世界,而通过显示屏看到的是一个二维的实时影像和虚拟信息混合的视频。那么,如果抛开由摄像机拍摄的实时影像,直接将信息添加到肉眼看到的影像上,会怎么样呢?

这就需要可穿戴的增强现实设备,比如头盔、眼镜、虚拟视网膜显示器等,它们都有一个共同点,就是这些镜片既是透明的,又可以当显示屏。我们透过它可以直接看到真实环境,同时,它还能把虚拟的内容显示出来,叠加到肉眼透过设备看到的现实场景中。

AR 设备的整合

谷歌眼镜是综合了上述原理的一种增强现实设备。

它用的是透明镜片,其中一个镜片上装配有投影设备和一个棱镜状的透明显示屏,计算机处理过的虚拟信息投影到显示屏上,再由这个显示屏反射到人眼的视网膜上。在你看来,就像是在现实世界叠加了一层半透明的虚拟信息。

你可以用位于眼镜右侧的一个触控板控制菜单的滚动,还可以用基本的声音命令收发短信、拍照、激活程序。它的人脸识别技术,可以让你在遇到一个人后,立刻将这个人的公开信息搜索出来并呈现在你的眼前。

此外,它加载的传感器可以捕捉一些特定的动作,比如你向后仰头到一定角度,这个动作可以作为唤醒睡眠模式的指令,还有你明显地眨下眼睛,就可以拍摄一张照片。

谷歌眼镜在医疗领域也有应用。

它能显示病人的电子病历。它的视频会议功能也很有用,与你连线的人可以通过前置摄像头直接看到你视野中的景象,用于帮助医生进行远程会诊。

微软的“HoloLens”智能眼镜更加强大,主要在于它实时生成虚拟图像的能力。

它既可以生成二维的数字内容,又可以生成三维的视频。

整个增强现实系统所做的就是:传感器捕捉真实图像信息反馈给电脑,电脑对信息进行处理,形成人们需要的虚拟信息,再投射到真实环境中,人可以与投射出的虚拟信息互动,做出手势,再由传感器捕捉并反馈。

当人进入增强现实

这是米斯特里(Pranav Mistry)在 2012 年展示的基于“第六感”系统的“WUW”。传感器装在 4 个指头上,利用这 4 个传感器组成的四边形,可以用手势自动为照相机取景

美国麻省理工学院的媒体实验室早在 1994 年就做了一个“第六感”系统,“第六感”的意思是这些可穿戴计算设备和数字信息可以为人类提供超过传统的五种感觉以外的感受。“第六感”系统的硬件简单又直观,同时也是增强现实的可穿戴设备的基本构成。它包括摄像头、小投影设备、智能手机,还有镜子。摄像头和小投影设备都与放在用户口袋中的智能设备连接,用户可以带着这些到处走。它的工作原理除跟常规的 AR 一样,摄像头获取环境信息,手机再根据这些信息调用增强信息外,更奇妙的地方是,用户可以用手势、肢体动作来操控这些投影出来的图像。比如,你在手腕上画一个圈,系统就会投影出一个显示现在时间的手表。在“第六感”系统里,这是由 4 种不同颜色的指套实现的,它们对应 4 种不同的光标,你可以使投射在墙上的图放大、缩小、分类等。据开发者说,不同颜色的指甲油也可以起到同样的作用。

虚拟的图像能放在三维空间的任何地方,这对设计师很有帮助 微软和美国国家航空和航天局联合开发了一个应用,科学家借此可以 直接获得探测器的视角,看到火星的虚拟全息影像

另外,你还可以选择安装一个麦克风。比如,你选择一张纸作为互动界面,将麦克风夹在纸上,它可以捕捉到用户接触纸张时发出的声音,然后传回给处理设备,再结合之前跟踪用户手指获得的信息,系统就可以精确辨别出你触碰的是纸张的哪个位置。

碎片名称:See the World through AR 在被“增强”的世界里-2

“增强”如何对准“现实”?

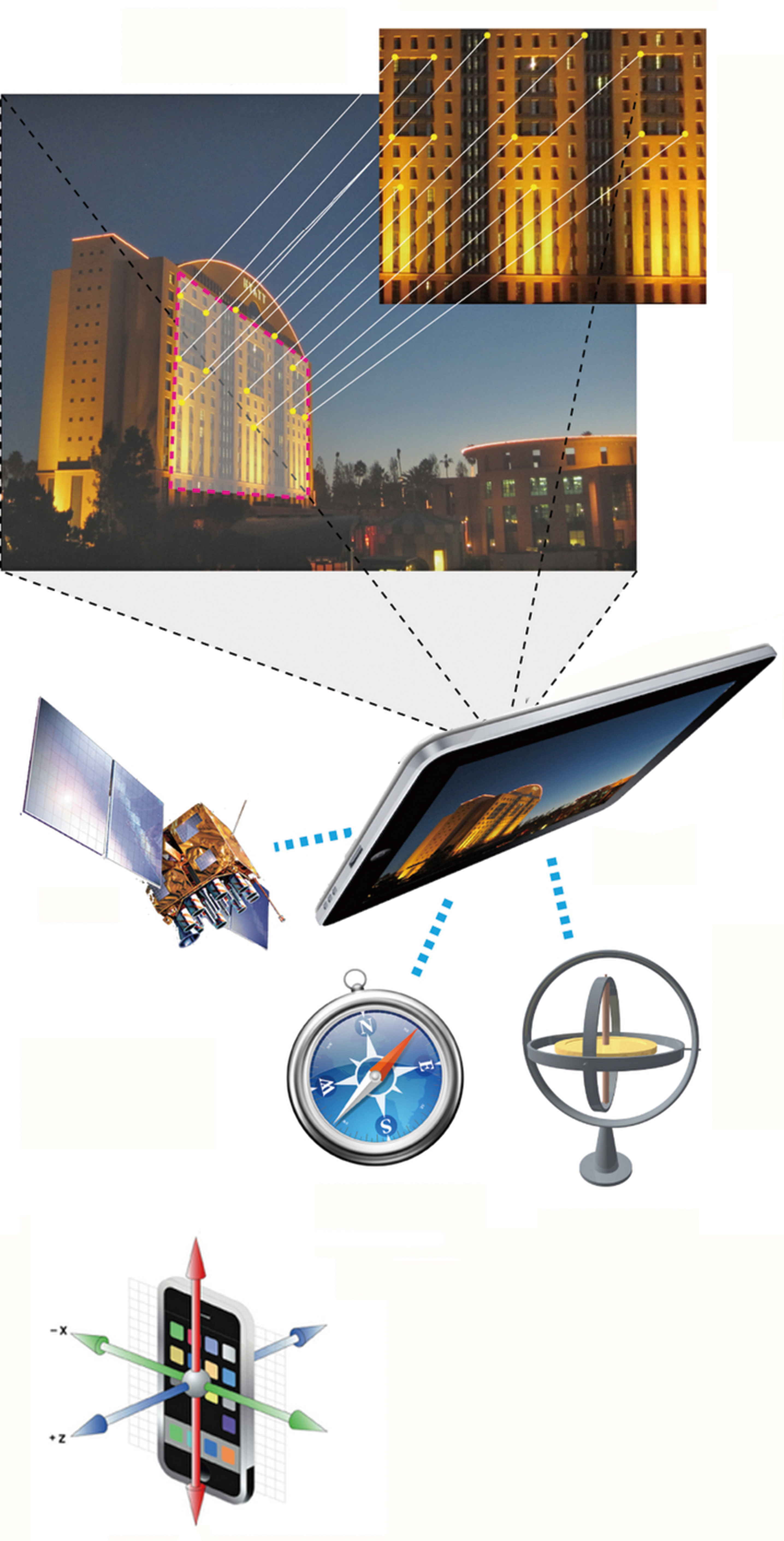

通过各种定位装置,包括对景物特征形状的辨识,可以将显示装置的所在位置、方位和俯仰等信息转化成为由 x 、y 、z 三个坐标轴组成的三维信息,这时,增强装置就对准“现实”了

理论上,摄像装置会捕捉周围真实环境进行场景采集并处理,转化为数据。

在人类眼中,复杂无序的真实环境经过计算机转化,就成为由 x 、 y 、z 三个坐标轴组成的三维网格空间,而环境中的物品,比如桌椅、餐具等都将被转化成复杂的几何体信息并被记录下来。

当计算机“读懂”了我们的真实环境,就可以把虚拟信息叠加到相应的坐标位置上,让我们看到虚拟信息与真实环境同时呈现。比如一杯虚拟的咖啡稳稳地放置在真实的桌子上,而不是悬浮在空中或者倒置。

此外,随着我们的头部位置和角度发生变化,我们眼中的真实环境也会随之发生变化,这个时候,场景采集会实时校准,虚拟物体的位置和角度也会随之变化。

当我们坐下来平视桌面时,看到的也许是咖啡杯身上的花纹,而当我们站起来俯视桌面时,就能看到咖啡表面的泡沫。(在这里,你也许已经意识到,这个增强现实已经用到虚拟现实的 3D 元素了。)

判断摄像头与环境的位置关系是视觉追踪中的重要一步。有一种比较便捷的视觉追踪方法,就是添加或利用标记识别。这些标记包括二维码、图像等。比如,在“AR Basketball”应用中,并不是随便一个物体都可以用来投篮,你需要找一个像图片中的杯子一样的物体,不过不用在意杯子的形状,它的秘密是杯子前面的二维码,这就是标记 — 能让应用程序识别并解码,计算出实际位置,最终在屏幕上生出一个虚拟的篮筐。

此外,如果摄像头可以探测红外波段的光,一些红外标记也可以被使用。

另外一种视觉追踪方法,就是通过系统对环境整体信息进行捕捉。系统可以捕捉环境图像中的光学特征,通过对比图像的变化,掌握环境情况,再跟系统中原来存储的环境模型进行匹配,确定摄像头所摄场景的确凿信息。

总体而言,基于特征的环境追踪是增强现实的总体研发趋势,不过基于特征的视觉识别具有不确定性,最重要的问题是,仅凭摄像头的视觉观察,无法从物体图像推测出物体的正确位置。因此,很多系统都是两种方法同时使用。此外就是利用更多种类的传感器。比如,我们戴上增强现实眼镜或头盔后不可能一动不动,如果我们的头部转动了,或者干脆从房间的一头走到另一头,头盔里具备 GPS 和陀螺仪功能的定位装置就会发挥作用,它不仅能够精准定位我们在真实环境中的位置,还能捕捉到头部角度的细微变化。

VR 和 AR,谁将主宰未来?

增强现实(AR)是将虚拟的图像加在我们看到的真实世界之上;而 虚拟现实(VR) 是让我们沉浸在一个 360°的虚拟世界里,没有真实世界的叠加,你的感官几乎和现实世界脱轨。有人把虚拟现实包括在增强现实的范畴内,认为虚拟现实是增强现实的一部分,比如微软的“HoloLens”,你遮上镜片,看到的就是虚拟现实。

总体来讲,两者的应用场景是不一样的。最近几年,游戏市场是虚拟现实装备销售的主要渠道,而增强现实技术将会被越来越多的汽车公司采用。未来,这两种技术的应用前景都具有很多可能。而随着对增强现实需求的拓展,增强现实里将有更多虚拟现实的表现元素,来全方位对接我们的生活、娱乐、学习、工作等。

“增强”如何对接“现实”?

眼镜中看到的虚拟景象

当我们确定物体的位置关系和尺寸后,就需要考虑接下来的问题——你想让一杯虚拟的咖啡在真实环境中呈现出什么样貌?

你可以制作二维图像,也可以用 3DMAX、MAYA 等专业软件做出非常精密的三维模型,呈现不同的颜色和材质,还可以模拟出与真实环境一致的光源。不论是窗外的自然光线还是房顶吊灯发出的光,都会在虚拟物品上产生不同的投影效果,影响它在我们眼中的真实程度。你的要求越高,获得的虚拟图像越逼真。

人可以感知三维世界,是因为人的大脑可以混合多种信息。

首先,人类具有立体视觉。1838年,英国科学家发现,人的左眼和右眼在看同一个物体时,视距有细微的不同,大脑通过对两个有差别的视觉信号进行处理,得到物体景深,在脑海里产生立体图像。这也是现在的3D 电影的基本原理。

此外,人类还拥有运动视差。头部和躯干的微妙运动可以让人在看距离较远的物体时获得更多的深度线索。

未来,出现在人们的视线中的可能是他们和它们

像“Oculus Rift”这样的头戴虚拟现实设备就可以准确模拟立体视觉和运动视差这两个线索。但是,在增强现实眼镜中,视觉问题要复杂一些。因为眼睛需要混合来自真实物体和虚拟物体的光线。真实的物体具有不同的景深,而虚拟物体实际上就是两张模拟视差的平面图像产生的立体图像,景深都是固定的。这会造成虚拟物体无法持续成为真实场景的一部分,也会导致佩戴者恶心、呕吐等。

目前,研究人员正在研究一种叫作“光场显示”的技术。它可以通过很小的凸透镜组成的阵列来反射具有不同景深的光线。它需要将一个二维的屏幕做成三维的光场,原来二维显示屏的像素要转化为“景深像素”就必须以降低分辨率为代价,光场技术的突破也正是解决这个矛盾的过程。

这些三维图像都是依靠穿可戴设备来实现的。有没有一种我们既不需要佩戴头盔,也不需要显示屏,通过肉眼就能直接看到的增强现实呢?有。全息影像可以通过各种高新技术,制作一种物理上的纯三维影像,观看者可以从不同角度不受限制地观察,甚至进入影像内部,触摸影像。

与此同时,随着玻璃等透明显示屏的普及,虚拟信息和现实环境将会有更丰富的互动。

不过,就像网络时代带来的垃圾信息泛滥、个人信息泄露等问题,增强现实会不会给人们带来新的烦恼呢?比如擦肩而过的陌生人通过面部识别就能获取你的年龄、体重、家庭等隐私信息;海量的广告信息扑面而来,你把胳膊挥酸了都没法把它们全部关掉;再比如你开始越来越厌倦在家里观看世界风光,而想回到真真正正的大自然中。这些我们还无从知晓。